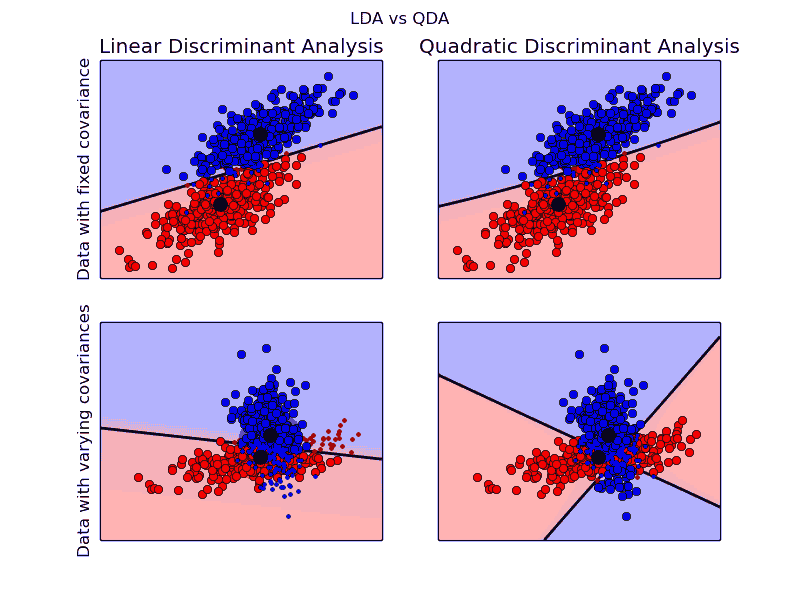

传统的降维方法,包括PCA、LDA等都是以观测数据点呈高斯分布模型为基本假设前提的,在已经先验经验知道观测数据集为非高斯分布模型的前提下,PCA和LDA的降维效果并不好;而本文介绍的ICA将适用于非高斯分析数据集,它是CIA,是主成分分析(PCA)和因子分析(Factor Analysis)的一种有效扩展。 独立成分分析(Independent component analysis,简称ICA)是一种利用统计原理进行计算的方法,它是一个线性变换,这个变换把数据或信号分离成统计独立的非高斯的信号源的线性组合。

独立成分分析的最重要的假设就是信号源统计独立,并且这个假设在大多数盲信号分离(blin